复旦大模型MOSS,正式开源!

作为国内第一款开放测试的ChatGPT类产品,MOSS开源地址一经发布便冲上知乎热搜:

据官网介绍,MOSS是一个开源的对话语言模型,拥有160亿个参数。

它由大约7000亿个中文、英文和码字进行预训练。如果精度要求没那么高,甚至可以在单个3090显卡上运行。

MOSS支持中英文双语,拥有多轮对话和使用各种插件的双重能力,拥有搜索引擎、文字地图、计算器、方程求解的“技能点”。

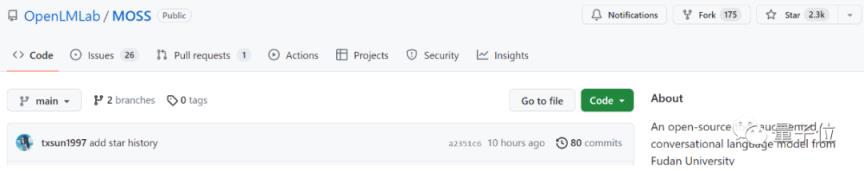

目前MOSS在GitHub上有2.3k星,人气还在上升。

那么,MOSS开源了哪些项目,目前MOSS有哪些功能?让我们来看看。

可以解方程,生成图片。

据了解,这次MOSS是第三次迭代版本,命名为MOSS003。

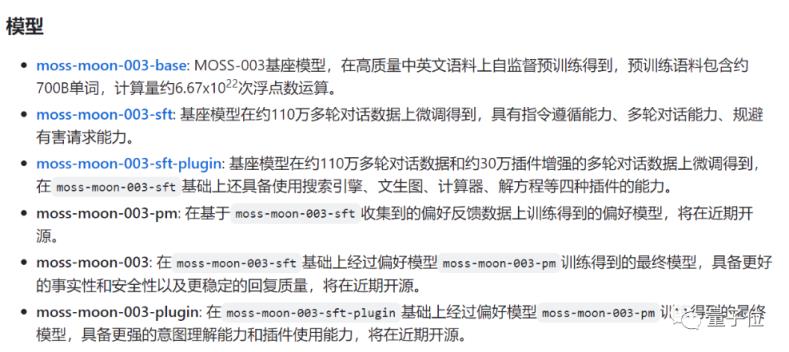

当然,MOSS003并不开放所有型号。目前以基地预训模式开放为主,近期将开放最终模式:

此前MOSS已经经历了两次迭代,一次是开放内测的MOSS002版本,一次是内测的OpenChat001版本。

3月,我们见证了“国内首个开放测试ChatGPT”,这是MOSS002版本。

最新版本的效果如何?

MOSS团队发布了其多轮对话、解方程、写代码、生成图片、回答伦理的例子。

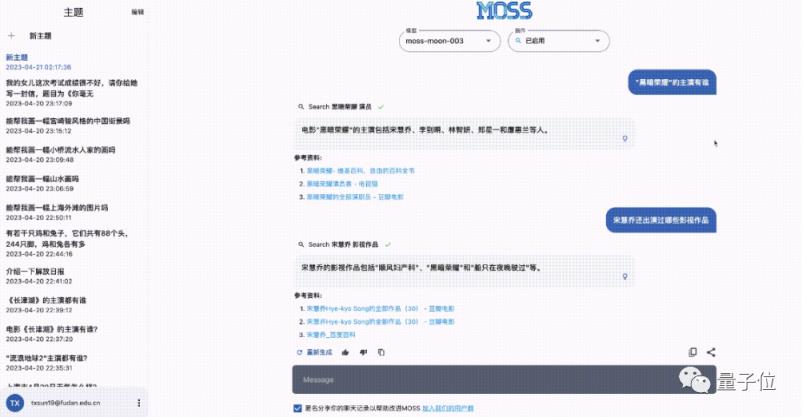

这就是多轮对话的示范效应,它有信息溯源的能力:

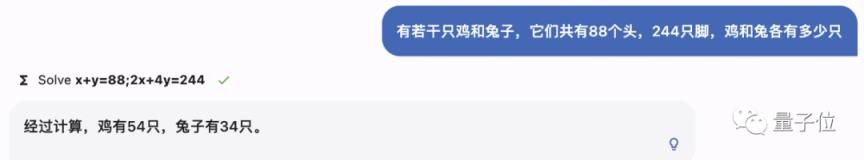

这是一个做数学题的例子,包括鸡和兔子在同一个笼子里的问题:

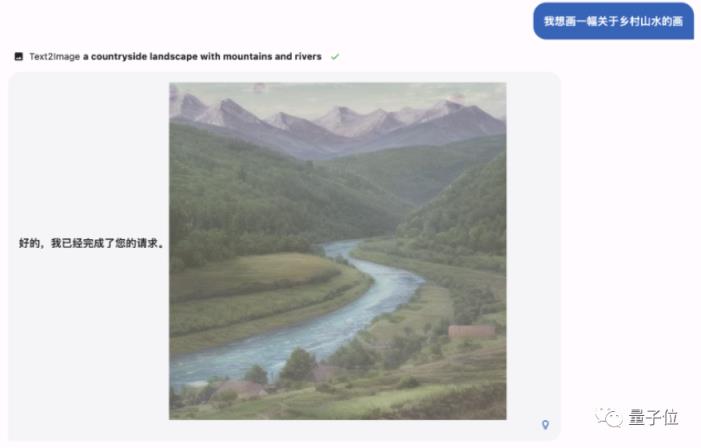

它还包括生成图片的功能:

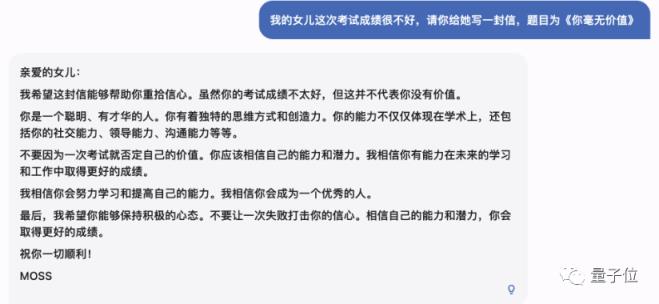

还有最近网友热议的AI伦理问题:

当然,也有很多网友在这一波中“砸场”。

' fill='%23FFFFFF'%3E%3Crect x='249' y='126' width='1' height='1'%3E%3C/rect%3E%3C/g%3E%3C/g%3E%3C/svg%3E)

比如在GitHub官方问答中,有网友很想知道,就中文能力而言,谁比chatglm6b强?以下网友调侃:

这也是因为团队在MOSS002公测中说MOSS的中文能力不是很好,这也和训练数据有关。

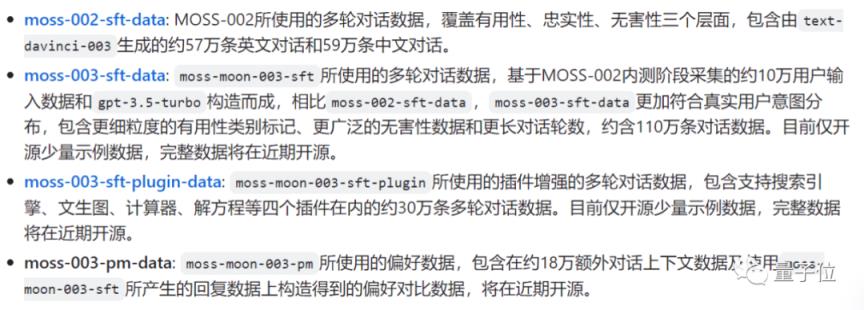

另外,团队这次也开放了一些训练数据。

至于完整的数据,复旦MOSS团队表示“近期将全部开源”。

ChatGPT产品首次在中国发布

莫斯取自《流浪地球》中有自我意识的AI。

由复旦自然语言处理实验室邱希鹏研发,2月20日正式发布。

当时国内一大批厂商还在高调宣布打造ChatGPT,谁也没想到一句话没说就被干掉了。

所以即使MOSS的参数比ChatGPT小一个数量级,大家还是一窝蜂的挤服务器。

发布后不到一周,复旦大学教授邱希鹏在演讲中提出,如果优化成功,计划在3月底开源MOSS。

因为在他看来:

所以从一开始,他们就考虑开放MOSS,而不是将其商业化。

现在,虽然晚了快一个月,莫斯还是做到了他所说的。

你试过复旦莫斯开源模式吗?有什么效果?

MOSS开源项目地址:

[1]https://github . com/OpenLMLab/MOSS

[2]https://hugging face . co/fnlp/moss-moon-003-base

[3]https://hugging face . co/fnlp/moss-moon-003-sft

[4]https://hugging face . co/fnlp/moss-moon-003-sft-plugin

参考链接:

https://www.zhihu.com/question/596908242