Daydx.com 5月10日消息:在很多人看来,类似OpenAI的ChatGPT的大型语言模型(LLM)就像一个黑匣子,因为即使是数据科学家,也很难知道为什么这些模型总是以自己的方式反应,就像空捏造事实一样。

为了分析LLM的行为,OpenAI正在开发一种工具,可以自动识别LLM的哪些部分对其行为负责。简单来说,在最新的发布结果中,OpenAI演示了用GPT-4来解释GPT-2的行为,并取得了初步成果。

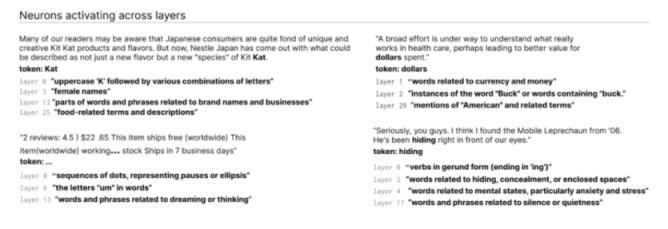

OpenAI开发的工具通过调用GPT-4来计算架构更简单的其他语言模型中神经元的行为。该工具为LLM中的每个神经元生成解释,这些解释被编译成与工具代码一起发布的数据集。

大模型(LLM)和人脑一样,是由“神经元”组成的,它会观察文本中的特定规律,然后影响模型本身产生的文本。

例如,有一个神经元代表“漫威超级英雄”。当用户问模型“哪个超级英雄的能力最强”时,这个神经元会增加模型在答案中告诉漫威英雄的概率。在开始之前,让GPT-2运行一个文本序列,并等待特定的神经元被频繁“激活”。

OpenAI开发的工具使用这个规则来分解模型。

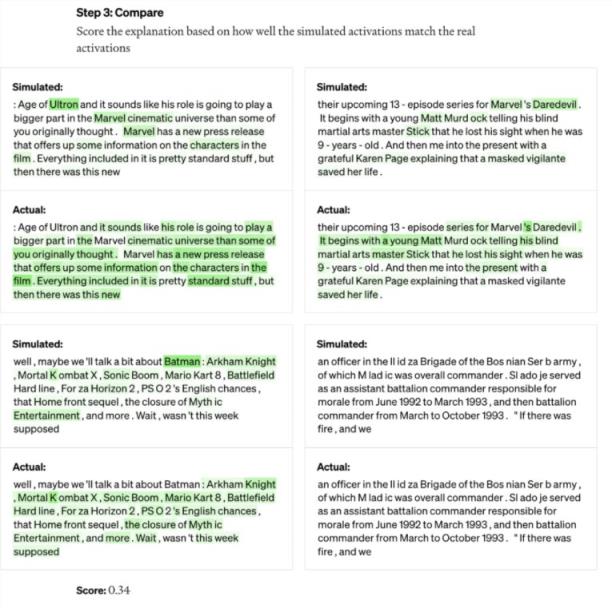

首先,让GPT-4为这段文字生成一个解释。比如下面这个案例,神经元主要针对漫威漫画内容。在接收到文本和激活后,GPT-4判断它与电影、人物和娱乐有关。然后,用GPT-4模拟GPT-2的神经元下一步要做什么,用GPT-4生成的模拟内容。最后,进行了对比评价。比较第四代模拟神经元和第二代真实神经元的结果,看看GPT-4有多准确。为了确保解释的准确性,该工具为GPT-4提供了一个文本序列,并让它预测或模拟神经元的行为。然后将模拟神经元的行为与实际神经元的行为进行比较。

OpenAI就这样对每个神经元的行为做出了初步的自然语言解释,并对这种解释与实际行为的匹配程度进行评分。

研究人员已经为GPT-2中的所有307,200个神经元生成了解释,并将这些解释汇编成数据集,与工具代码一起发布在GitHub上。

背后的工程师强调,它还处于早期阶段,但它的运行代码已经可以在GitHub上以开源的方式获得。OpenAI的工具可以帮助研究人员更好地理解LLM的行为,从而提高性能,减少偏差或毒性。

一些人还质疑该工具本质上是为GPT-4做广告,因为它需要GPT-4才能工作。其他解释LLM的工具较少依赖商业API,比如DeepMind的Tracr。